每周安全速遞3?? | Everest勒索組織聲稱對寶馬進行攻擊

2025-09-26

第一!美創數據庫防水壩位居中國數據庫安全運維管理市場份額榜首

2025-09-24

2025網安周|美創科技多地聯動,共筑數據安全防線

2025-09-19

國家網信辦發布《國家網絡安全事件報告管理辦法》

2025-09-16

數字醫學與健康大會DMHC——美創與您相約古都金陵

2025-08-12

存儲域

數據庫加密 諾亞防勒索訪問域

數據庫防水壩 數據庫防火墻 數據庫安全審計 動態脫敏流動域

靜態脫敏 數據水印 API審計 API防控 醫療防統方運維服務

數據庫運維服務 中間件運維服務 國產信創改造服務 駐場運維服務 供數服務安全咨詢服務

數據出境安全治理服務 數據安全能力評估認證服務 數據安全風險評估服務 數據安全治理咨詢服務 數據分類分級咨詢服務 個人信息風險評估服務 數據安全檢查服務在生成式 AI 爆發式滲透職場的當下,從起草郵件的聊天機器人到賦能決策的大型語言模型(LLM),全球企業正以前所未有的速度將 AI 工具嵌入核心業務流程。數據顯示,75% 的職場人士日常依賴 AI 提效,超半數企業部署了兩種以上 LLM 以優化運營。

然而,當效率革命的引擎轟鳴作響時,安全剎車片卻嚴重失靈:員工通過個人賬戶私自接入消費級 AI 工具的行為已形成 “影子 AI” 生態,近 90% 的主流 AI 平臺被曝存在數據泄露歷史,甚至連 OpenAI 等頭部 LLM 供應商也因 SSL 漏洞、憑證管理混亂等問題淪為攻擊靶心。這場始于效率追求的智能化轉型,正演變為一場 “工具濫用” 與 “監管真空” 交織的安全危機。

國外近期的調查報告揭示了一個明顯趨勢:員工在未經雇主批準、IT 監督或明確安全政策的情況下,正快速采用消費級AI工具。根據 Cybernews《企業數字指數》報告,近 90% 受分析的AI工具曾遭遇數據泄露,使企業面臨嚴重風險。

報告顯示,約 75% 的職場人士在工作中使用AI,其中 AI 聊天機器人是最常見的輔助工具。雖然這提高了工作效率,但也可能導致企業面臨憑證盜竊、數據泄露和基礎設施漏洞風險,特別是考慮到僅有 14% 的工作場所制定了正式 AI 使用政策,導致員工使用行為缺乏追蹤。值得注意的是,在使用 AI 工具的員工中,約三分之一的使用行為未被管理層察覺。個人賬戶的濫用進一步加劇了安全隱患。

根據谷歌 2024 年對 1000 多名美國知識工作者的調查,93% 的 Z 世代員工(22-27 歲)在工作中使用兩個及以上 AI 工具。千禧一代緊隨其后,79% 的員工展現出相似的使用習慣。這些工具被用于起草郵件、整理會議紀要以及彌合溝通鴻溝。這種跨代際的高頻使用趨勢,直接放大了安全風險——埃隆大學 2025 年的調查發現,58% 的 AI 用戶定期依賴兩個及以上不同模型。而工具切換過程中的數據殘留和權限繼承問題往往被忽視。

Harmonic 數據顯示,45.4% 的敏感數據請求通過個人賬戶提交,完全繞過了企業監控系統。“工作場所對多種 AI 工具的無序使用,特別是通過個人賬戶操作,給企業安全造成了嚴重盲區。”企業級安全 AI 編排平臺 nexos.ai 首席技術官 Emanuelis Norbutas 對此強調:“每個工具都可能成為敏感數據的外泄點,并完全脫離 IT 治理體系監管。缺乏清晰監管的情況下,政策執行、使用監控和合規保障幾乎無從談起。”

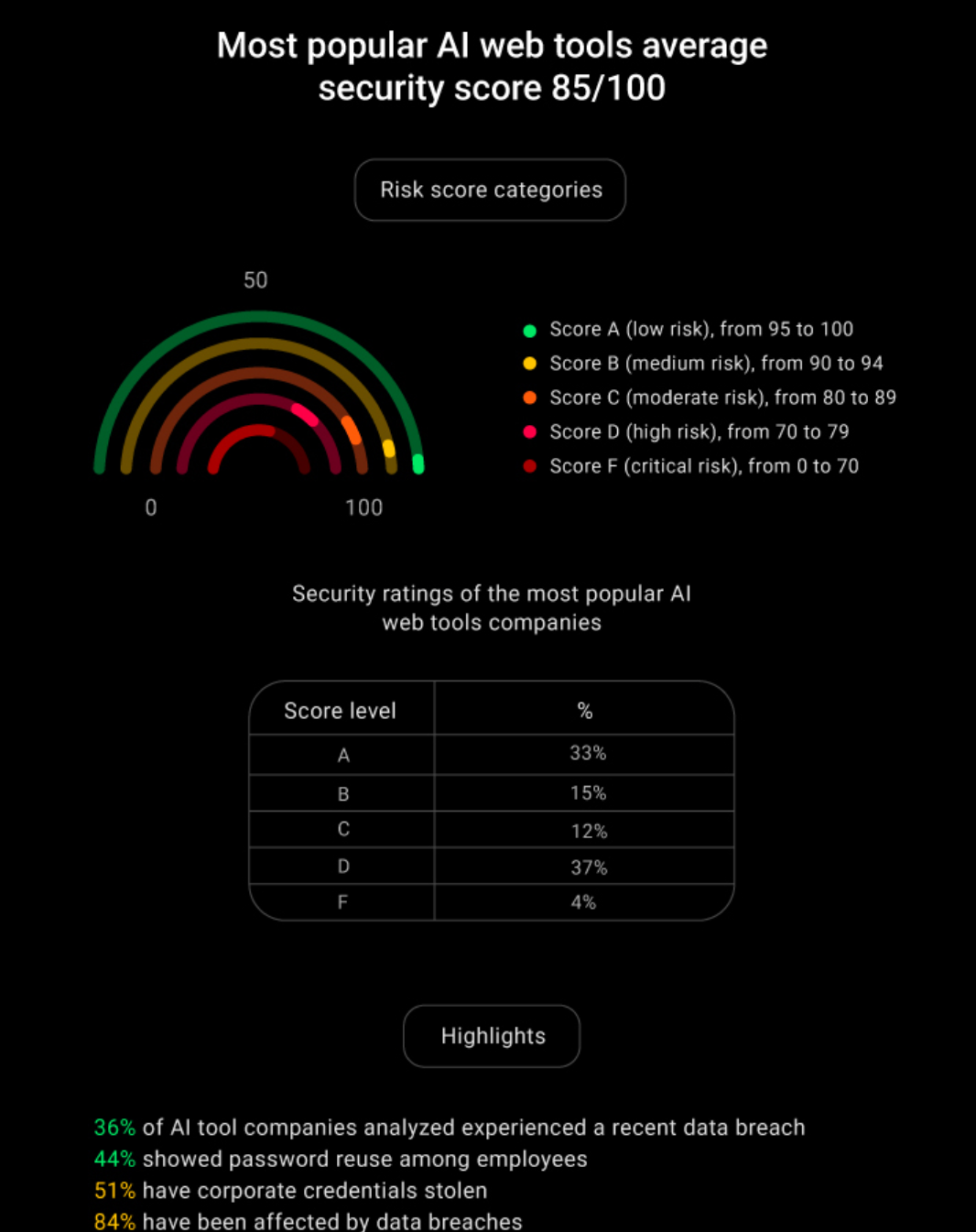

為評估工具實際的安全表現,Cybernews 研究人員在 2025 年 2 月分析了 52 個熱門 AI 網絡工具(基于 Semrush 流量數據篩選)。研究顯示:盡管平均網絡安全得分為 85 分(滿分 100),但 41% 的平臺僅獲 D 或 F 評級。33% 的平臺獲得 A 級認證,突顯行業安全水平兩極分化。這種懸殊差距的根源在于——頭部企業往往依賴單一防護技術(如加密算法)拉高均分,卻忽視系統托管、密碼管理等基礎安全環節。

“高分均值不意味著工具絕對安全。”Cybernews 安全研究主管 Vincentas Baubonis 警告:“工作流中的任何薄弱環節都可能成為攻擊突破口。一旦入侵,威脅分子就能橫向穿透系統、竊取企業敏感數據,甚至部署勒索軟件。”

研究指出,84% 的 AI 工具曾發生數據泄露,其中 36% 在過去 30 天內遭攻擊。93% 存在 SSL/TLS 配置缺陷,導致數據傳輸加密強度被削弱,攻擊者可輕易攔截敏感信息。與此同時,91% 的平臺存在系統托管漏洞,過時的服務器設置持續擴大攻擊面。更嚴峻的是,44% 的 AI 開發企業存在員工密碼復用現象,而 51% 的工具發生過企業憑證失竊事件,這些漏洞為后續數據泄露埋下隱患。

“許多 AI 工具在設計時就未考慮企業級安全需求。”Norbutas 指出:“員工常默認這些工具天然安全,但事實是大量工具已被攻破。當密碼被復用或存儲不當時,攻擊者就獲得了入侵企業系統的直通車。”

此外,在筆記記錄、日程管理和內容生成領域使用的生產力工具中,暴露出了最嚴重的安全隱患:每家公司平均失竊憑證達 1332條,其中92%的公司存在數據泄露,且所有工具均存在系統托管及 SSL/TLS 配置問題。

“這是典型的阿喀琉斯之踵困境。”Baubonis 分析稱:“表面安全的工具可能因單一漏洞全盤失守。以 Hugging Face 平臺為例,一個盲點就足以摧毀數月建立的安全防線。”該案例的警示在于——即使工具本身具備高安全評分(如Hugging Face獲A級認證),若企業未對員工操作行為(如通過個人賬戶上傳敏感數據)實施管控,仍可能導致系統性崩潰。

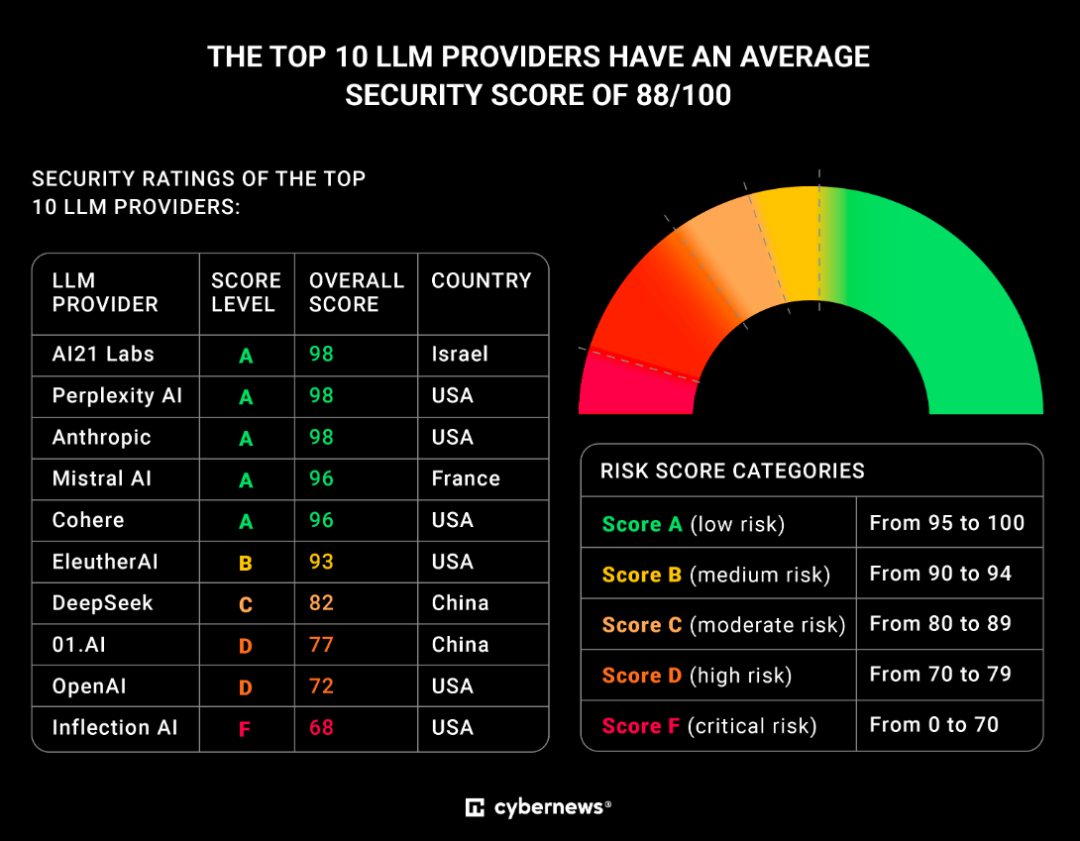

除通用型工具外,大型語言模型(LLM)這一細分領域的安全風險尤為突出。即使 58% 的大型語言模型(LLM)用戶已嘗試過兩種及以上不同模型,且全球企業正加速部署 LLM 以優化運營、生成內容并賦能員工,但 Cybernews《企業數字指數》最新分析表明,許多職場 AI 工具的安全性遠低于企業預期,正危及敏感數據和品牌聲譽。

在 LLM 使用場景中,Harmonic 數據顯示,45.4% 的敏感數據請求通過個人賬戶提交,完全繞過企業官方通道。這種操作模式使企業難以實施跨平臺安全管控,往往在不知情時已暴露數據,引發對 AI 工具選型與集成的深度擔憂。《企業數字指數》揭示,所有 LLM 供應商均存在 SSL/TLS 配置漏洞。若企業 SSL/TLS 設置不當,敏感數據可能遭中間人攻擊截獲,直接威脅用戶信任與數據安全。

具體泄露事件顯示,五家供應商存在歷史泄露記錄。其中 OpenAI 遭受 1140 次數據泄露,最近一次發生在分析前 9 天;Perplexity AI 在分析前 13 天泄露 190 條企業憑證。憑證泄露危機因密碼復用現象持續加劇:Perplexity AI 員工中 35% 使用已泄露密碼,EleulerAI 員工密碼復用率達 33%。

系統托管漏洞同樣普遍存在。除 AI21 Labs 和 Anthropic 外,所有供應商均存在顯著托管安全問題。Perplexity AI 與 EleulerAI 近 40% 系統部署于云端,更易遭受潛在攻擊。地域安全對比顯示,美國 AI 供應商平均安全得分 87.5,顯著高于其他國家。安全表現最佳的三大供應商(AI21 Labs、Perplexity AI、Anthropic)包括美國和以色列企業,盡管美國整體得分較高,但其企業 Inflection AI 卻成為墊底案例。

在生成式 AI 引發的安全范式變革中,全球頂尖專家與權威機構已形成共識:AI 安全絕非單一技術問題,而是涉及技術架構、政策治理與國際協作的系統性工程。

技術方面,四川大學網絡空間安全學院任昊團隊在 AAAI 2025 提出的研究成果揭示,AI 系統的安全漏洞具有 “全生命周期滲透” 特征。例如,深度神經模糊推理系統(DNFIS)在醫療診斷場景中,用戶敏感數據在傳輸和存儲環節存在被竊取風險,而傳統加密協議難以適配模糊隸屬函數的復雜計算需求。為此,團隊開發的 PrivDNFIS 方案通過同態加密與密文提取技術,將端到端時間開銷降低 1.9-4.4 倍,同時在半誠實威脅模型下提供形式化安全證明。這種 “安全即效率” 的設計理念,為醫療、金融等關鍵領域的 AI 應用提供了可落地的技術范本。

加拿大薩斯喀徹溫大學網絡安全專家 Natalia Stakhanova 博士進一步指出,AI 的 “雙刃劍” 效應在攻防兩端同時放大:攻擊者可利用 AI 生成對抗樣本繞過檢測系統,而防御方同樣可通過 AI 模擬大規模攻擊以強化防御體系。她特別強調,企業需建立動態攻防驗證機制—— 例如通過對抗訓練提升模型魯棒性,或部署實時特征軌跡監控系統(如四川大學 GRIMM 模型),在不改變原有 GNN 架構的前提下,識別并修復中毒攻擊導致的異常邊擾動。

政策方面,國家發改委在《夯實人工智能發展的安全基礎》報告中明確,數據安全是 AI 安全的核心基石。報告指出,71% 的企業 IT 領導者認為生成式 AI 加劇了數據泄露風險,微軟、亞馬遜等科技公司已限制員工使用消費級 AI 工具。為此,中國近年密集出臺《生成式人工智能服務管理暫行辦法》《互聯網信息服務深度合成管理規定》等法規,要求企業將數據安全嵌入模型訓練、部署全流程,并建立算法備案與風險評估制度。

加州 SB 1047 法案的實踐則提供了另一種思路:要求前沿 AI 模型開發者設置 “安全開關”,并對違規行為實施高額罰款與系統關停。這種 “技術硬約束 + 法律強威懾” 的組合,雖引發開源社區爭議,但被 Elon Musk 等科技領袖視為 “防止 AI 技術濫用的必要代價”。值得注意的是,歐盟《人工智能法案》采取了差異化監管策略 —— 根據風險等級對 AI 系統分類治理,既避免 “一刀切” 抑制創新,又確保高風險場景(如自動駕駛)的絕對安全。

國際協作方面,圖靈獎得主 Yoshua Bengio、姚期智等在威尼斯共識中強調,AI 安全是 “全球公共產品”,需建立跨國應急響應機制與獨立驗證體系。他們建議:

1、模型注冊與披露制度:要求開發者公開模型架構、訓練數據來源及潛在風險;

2、安全保障體系:對高性能 AI 系統實施部署后監控,并引入第三方審計;

3、全球獨立研究網絡:由多國政府與慈善機構共同資助,開發可驗證 AI 安全聲明的通用技術。

這種協作理念已在實踐中初顯成效。例如,英國 NCSC 聯合 18 國發布的《AI 網絡安全指南》,將安全設計嵌入開發、部署、運行全生命周期,要求默認開啟自動更新并建立透明響應機制。中國則通過《全球人工智能治理倡議》,推動與 “全球南方” 國家共享 AI 安全技術,助力縮小數字安全鴻溝。

從消費級工具的個人賬戶濫用,到企業級 LLM 供應商的系統性漏洞,當前 AI 應用的安全風險已呈現 “雙向滲透” 態勢。企業在享受 AI 提效紅利的同時,正面臨前所未有的數據安全與合規挑戰 —— 個人賬戶成為敏感數據 “暗渠”,工具自身的 SSL 缺陷、托管漏洞與密碼復用問題構成攻擊鏈閉環,而頭部供應商的評級落后與地域安全鴻溝,更暴露出行業標準化安全框架的缺失。

隨著生成式 AI 加速融入醫療、金融、政務等關鍵領域,威脅分子對 AI 工具漏洞的利用將更趨精準化、產業化。企業需突破 “工具安全等于整體安全” 的認知誤區,從政策層(制定 AI 使用規范)、技術層(部署跨平臺監控系統)、供應商層(嚴格安全審計)構建三維防護體系。監管機構與行業組織也應加快推動 AI 安全標準落地,填補 “技術創新快于安全治理” 的發展失衡。

正如《企業數字指數》揭示的,AI 工具的真正價值,始于對 “安全即基礎設施” 的清醒認知。唯有將數據安全嵌入每一次工具選擇、每一行代碼設計、每一條使用流程,才能在智能化浪潮中筑牢數字安全防線,避免 “效率提升” 淪為 “風險敞口” 的代價。